作者:周志峰、胡奇,均為啟明創投TECH投資團隊成員,周志峰是啟明創投合伙人,胡奇是啟明創投投資經理。

來源:未盡研究

圖片來源:由無界版圖 AI生成

編者按:

今年以來,由遊戲設計師傑森·艾倫使用AI繪圖工具Midjourney繪製的作品《太空歌劇院》奪下了美國科羅拉多博覽會的年度藝術比賽的首獎,引起藝術家和社交媒體的熱議,也讓AIGC(人工智能自動生成內容)概念成為AI界年度熱詞,並掀起了一股AIGC投資熱潮。AIGC真如外界所宣傳的那般美好嗎?其背後的創新創業生態將如何構建?

從2012年AlexNet取得深度學習里程碑式的突破以來,啟明創投在過去的十年中都是中國最活躍的人工智能投資機構之一,我們見證了人工智能從算法到應用的一次次突破和發展,對人工智能的前景我們始終保持着熱情和理智。啟明創投開設硬科技前瞻專欄,希望從創投視角深度解讀前瞻技術突破,多維度剖析行業趨勢,尋找新銳科技力量。

如果我和你說,未來AIGC可能有兩種世界:一種世界是多個大模型基礎公司,為上游應用提供API和模型服務,上游應用公司只需要專註於開發產品邏輯和上層算法;而另一種世界則如同今天的AI公司一樣,每家公司都根據自身需求研發底層大模型,為自身應用提供技術支持。

你對任何一種世界的相信都將構成你當下投資和創業的選擇,當然,這兩種世界也可能存在互相交織的過渡形態,但需要你來對過渡形態的持續時間進行判斷,你會選擇相信哪一種世界?

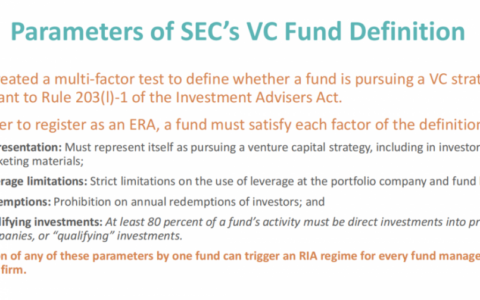

AIGC的兩種世界

先不用着急給出你的答案,再問你兩個問題:

1、如果GPT-4,或者3年、5年後最好的模型比GPT-3大100倍甚至1000倍,作為創業公司是否還要自研?

2、在某個領域的底層基礎模型尚未成熟的時候,選擇在該領域進行創業是很好的timing嗎?

如果你對未來的AIGC世界和這兩個問題感興趣,我們將進入今天的文章。我們將簡單回顧近期熱鬧的AIGC,從中探尋AIGC在今年火爆的根本原因,並將結合強化學習奠基人之一Rich Sutton的“AI 70年慘痛的教訓”和Jasper.AI、Copy.AI等公司的發展,做出我們對於這個世界的判斷。相信看完以後,你也將會得出自己的答案。

引爆用戶的AIGC

如果用一個字形容過去幾個月的AIGC(AI Generated Content)/Generative AI那麼應該是“火”。Midjourney的作品獲得美國科羅拉多州博覽會的數字藝術比賽一等獎,引發關注和廣泛爭論,有人戲稱AIGC讓每個畫師都在擔心失業。與此同時,今年相對沉寂的VC迎來新風口,連續轟炸的AIGC公司的融資消息和新聞讓VC又一次產生FOMO (Fear of Missing Out)的情緒;DreamStudio、Midjourney等AI作畫應用符合視覺消費的時代主題,引爆了C端熱情。

Midjourney的獲獎作品 – 太空歌劇院

Théâtre D’opéra Spatial

其實AIGC並不是一個新穎的概念,AIGC即用AI算法生成文本或者圖像等內容,各種NLG(自然語言生成) 模型和GAN(生成對抗網絡)及其變種模型都是此前的生成式AI模型。如果你打開谷歌搜索AIGC,會發現排在前面的基本都是中文網站,因此有人說AIGC是一個國產概念,與之對應的海外概念是Gartner在2019年提出的Generative AI,為統一理解,本文將採用AIGC來表達AI生成內容。

我們觀察到新一波AIGC浪潮起源於2020年的預訓練大模型GPT-3,現在火爆的圖像生成、視頻生成、3D生成等,本質是大模型從文本生成擴展到多模態,並結合原有模態算法進行實現(當然,以圖片生成圖片等本模態之間的AI生成,以及圖像生成視頻、2D生成3D等跨模態生成也是AIGC,例如VAE、StyleGAN、Nerf等與AI生成相關的模型都在GPT-3發布之前或之後提出,但這些方向的工作並非引爆新一波AIGC的主要原因)。因此,我們看到的大量AIGC應用,目前的表現形式大多為輸入一句話,生成一句話/一張圖/一段視頻/一串代碼等。

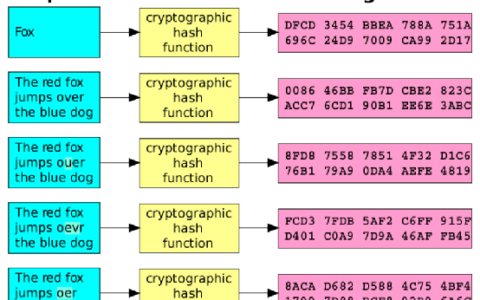

1750億參數的GPT 3曾一度是AI歷史上最大的機器學習模型,相比於15億參數量的GPT 2,GPT 3參數量提高約117倍,預訓練的數據量也從50 GB提高到570 GB。2020年發布GPT 3的時候,OpenAI並沒有將工作重點放在模型結構的創新上,反而是進行了大量工程化的工作,充分展示GPT 3通過Zero-Shot、One-Shot和Few-Shots(即不需要額外數據進行微調,直接給出幾個樣例就可以讓模型做出正確的生成)等Prompt方法完成多種NLP任務的通用性和泛化能力。通過釋放出API接口供公眾調用,GPT-3的商業化也正式提上日程。GPT-3展示出驚人的效果后,一年後頂級實驗室和科技大廠陸續發布自己的NLP預訓練大模型,模型參數量呈現指數級別的增長。

深度學習模型中參數數量的指數級增長

隨後的一年內,OpenAI進行了多次多模態的探索,其中最知名的是Text-to-image系列模型DALLE和DALLE2。

OpenAI在2021年1月發布初代Text-to-Image 模型 DALL-E,雖然相比於此前作畫模型進展驚人,但效果並未讓大眾驚艷,因此只在學界引發了巨大的關注。2022年4月,OpenAI再次發布第二代Text-to-Image 模型 DALL-E 2,效果極好,但OpenAI僅用一篇未公布細節的論文展示其成果,並僅為審核通過的開發者提供接口試用。2022年8月,借鑒Dall-E 2的思路,Stable Diffusion模型開源,至此,AI圖像生成開始爆發。

DALLE、 DALL-E 2和其他開源模型發布時間

時間軸圖片來源:State of AI Report 2022, https://www.stateof.ai/

總結AI生成圖像發展滯後於生成文本,但卻在2022年下半年爆發的原因,我們不難發現如下規律,上一層級的AIGC往往依賴於下一層級的AIGC發展到一定程度,如Text-to-Image依賴於Text-to-Text本身的算法發展相對成熟,同理,我們推測Text-to-Video也需要依賴Text-to-Image和其他視頻預測算法(如視頻插幀)的發展成熟,因此,我們可以對不同複雜度的AIGC內容的進化路線得出以下推論:

AIGC中不同內容的進化路線

AIGC為何引起新一波熱潮?

如果分析新一波AIGC得到發展的原因,最直接的結論是因為大模型(如GPT-3、Dalle2、Stable Diffusion等)帶來了非常好的效果和泛化能力。

其實從GPT-3出現之前,早在2018年3.4億參數的Bert模型在當時已經算是巨無霸級別的存在,只是沒有想到短短2年內,模型參數就提高到了GPT-3的1750億。3.4億參數的Bert將SQuAD 1.1的F1得分提高到93.16分,超過人類的表現,並用屠榜的成績贏得了多項NLP測試。但直到GPT-3的出現,NLP模型才可以更好地完成NLG任務,並且對Few-shots的運用更加嫻熟。

大模型還展示出了強大的泛化能力,GPT-3的API接口讓下游的應用公司可以不需要遷移學習就直接將AI能力應用到自己的任務中,API接口發布不到1年內就吸引了約300家公司調用其API,也印證了在2021年8月斯坦福大學教授李飛飛等100多位學者聯名發表的200多頁的研究報告On the Opportunities and Risk of Foundation Models中關於大模型(統一命名為Foundation Models)可以集中來自多種模態的所有數據的信息,並直接適用於多種下游任務的構想。藉助GPT-3的API接口,OpenAI也逐漸從獨立的實驗室走向大模型的基礎設施公司。

圖片來源:論文On the Opportunities and Risk of Foundation Models

但如果進一步對為什麼大模型能夠帶來更好的效果和泛化性進行分析,我們目前還只能通過實驗而非清晰的理論進行解釋。的確大多數情況下更大規模的模型會帶來更好的效果,但具體原因尚未被探明,學術界也存在很多探討。在最新的一篇關於大模型的研究論文中,作者通過實驗證明了大多數任務的效果隨着模型的增大而提高——在一些任務中,隨着模型增大而效果類似線性相關地變好的情況,作者將這類任務定義為Linearity Tasks,同樣,也有一些任務需要模型規模超過某個臨界點后,會突然出現相應的能力,此後在隨着模型規模的增大而提升效果,作者將這類任務定義為Breakthroughness Tasks。(當然,也存在少部分任務的效果隨着模型增大而降低)。

圖片來源:論文Beyond the Imitation Game: Quantifying and extrapolating the capabilities of language models

同樣,論文Emergent Abilities of Large Language Models中也有類似的實驗證明,當模型達到臨界大小時,許多NLP能力會不可預測地出現——湧現規律。

如果再進一步追問為什麼模型可以越做越大,則不得不提到Transformer的優點。Transformer解決了并行化訓練和長依賴問題,能夠容納更多的參數規模,為模型進一步做大提供了基礎,而大模型帶來了更好的效果和泛化性,提供了超過以往的生成能力,引發了新一波AIGC的爆發。

Transformer提供的并行化和對全局信息掌控能力,對算力的充分挖掘和利用,也近乎完美地符合2019年 DeepMind傑出科學家、強化學習的奠基人之一的Rich Sutton在文章The Bitter Lesson中論述的觀點——從過去70年的人工智能研究中可以得到的最大教訓,是利用計算的一般方法最終是最有效的,而且效果提升幅度很大。

在文章中,Rich Sutton通過列舉深度搜索超過人類知識設計的算法而在計算機國際象棋中擊敗人類冠軍、隱性馬爾可夫模型在語音識別領域戰勝基於人類知識的算法、計算機視覺中深度學習使用卷積超過此前搜索邊緣和以SIFT特徵為基礎的方法,論證了為了尋求在短期內有所作為的改進,研究人員更傾向於利用人類對該領域的知識,但從長遠來看,唯一重要的是對計算的利用。

然而, Rich Sutton關於“長遠來看,唯一重要的是對計算的利用”的觀點,當時並沒有引發業界的強烈關注,甚至在大模型促進AIGC蓬勃發展的今天,很多創業者和投資人仍然沒有對這句話的意義足夠重視。

未來的世界

目前關於GPT-4流行着兩種傳言,第一種是生成GPT-4並不會比GPT-3的參數規模大太多,預計是幾千億級別的參數量,但會使用更大量的數據進行訓練;另一種傳言是GPT-4的規模將會比GPT-3大至少一個量級。不管哪一種傳言是對的,如果我們認真思考Rich Sutton的“長遠來看,唯一重要的是對計算的利用”這一觀點,則很難避免的需要回答這樣一個問題“如果GPT-4,或者3年、5年後最好的模型比GPT-3大100倍甚至1000倍(這裡的100倍,可能是模型參數量、也可能是訓練使用的數據量),作為AIGC應用側的初創公司還是否要自研?”

2012年至今,表現最好的模型參數

每18個月增加35倍,增速遠超摩爾定律

我們在今天熱鬧的AIGC創業氛圍中,有時會聽到這樣的一種樂觀言論—市場上能夠調用的大模型API效果並不好,我們需要得到一筆融資,去研發自己的大模型,有了自研的大模型,我們想要做的殺手級別的應用(如寫作助手、圖畫生成等等)就會取得更好的效果,最終贏得客戶。持這種論調的創業者,大多有着不錯的技術背景,並且大概率在AI領域有過一些值得人尊敬的成果。然而,Rich Sutton之所以得出慘痛的教訓,正是因為基於這樣的歷史觀察:1)人工智能研究者經常試圖將認知加入到他們的模型中,2)這在短期內總是有幫助的,並且對研究者個人來說是滿意的,但是3)從長遠來看,它的影響趨於平穩,甚至抑制了進一步的進展,4)突破性的進展最終通過一種與之對立的方法,是基於搜索和學習這樣能夠擴展計算的方法。

這樣的觀察與上文我們觀察到的一些論調非常相似,今天創業者希望通過利用與自身業務相關的數據、經驗、技巧等去自己構建當下的最好的大模型,的確有機會在自身領域帶來超過今天大模型基礎設施公司公開提供API的效果,然而這也同樣意味着企業要一直分配一大部分精力和資金在基礎模型的研發上,那自然放在業務上的資金和精力則會減少。PMF(Product-market fit)以及PMF之後的業務拓展,都需要企業投入全部的精力來完成,這大模型所需要耗費的研發投入和資金成本顯然與集中精力做PMF有一些矛盾。

對於以上的問題,目前AIGC創業公司中已經實現PMF和商業化拓展的兩個代表性公司Copy.AI和Jasper.AI並未糾結。前者在成立的一年內實現了1000萬美元的ARR,而後者則更是厲害,在成立的2年內實現了4000萬美元的ARR,預計在今年實現9000萬以上的ARR。兩者的共同點都是基於選擇了使用GPT-3提供的API進行創業,並在GPT-3提供的API的基礎上,在前端做了大量的控制算法和產品邏輯,並集中精力打磨產品。

值得警惕的是,大模型是一直在進步的,耗費的成本也越來越高。OpenAI 1750億參數的GPT-3耗費了大約500萬美元的訓練資金,Stability.AI也在維護一個4000 多個Nvidia A100 GPU組成的集群來訓練AI模型,顯然這麼大的訓練費用對於創業公司是一個壓力。雖然Stable Diffusion已經開源,但在圖文生成領域還有更多進步的空間,目前來看Stability.AI的方向並非成為圖像側的應用公司,而是成為大模型領域的基礎設施公司(可能類似於hugging face)。那麼不禁要問,如果有一天Stability.AI像OpenAI一樣,並不再開源其最先進的模型,而是提供商業化調用的時候,創業公司是否還要選擇自研大模型來保持最先進,如果回答是Yes的話,資金又要從哪裡募集呢?

另外一個值得注意的問題是,目前Stable diffusion開源模型所展示的效果並沒有在圖像領域達成如GPT-3在NLP領域一樣的效果,雖然其C端火爆的現象仍然持續,然而如果真的轉化成B端的通用生產力工具,Stable diffusion還存在無法針對圖像做更細節的生成(如手部效果等)、無法制定某個特定區域修改乃至修改後與原場景十分融洽、無法控制畫作中不同元素(實體)進行單獨修改等諸多問題(截止發稿前,Stable diffusion2.0已經在11月24日發布,變化包括對分辨率的提升、引入圖片編輯功能等,但上述問題仍然未得到充分解決)。簡而言之,目前除了NLP領域的大模型是相對成熟以外,圖像的AIGC模型尚且處於早期,視頻、3D、遊戲等內容的AIGC模型則處於更早期階段。因此創業者需要回答的另一個問題是“當底層基礎模型尚未成熟的時候,是選擇在該領域進行創業很好的timing嗎?是否應該等到底層模型相對成熟且API就位后才是更好的創業timing?”

以Text-to-Image領域為例,自然會有一些勇敢的創業者會去提高當前Stable diffusion的效果,自己訓練前端的CLIP模型,甚至自己訓練後端的Diffusion模型。的確,在當前模型沒有發展到一定程度時,拿到一筆錢后做出比當下市場上最好的模型效果還要好的模型,並為業務產生更好的效果的想法確實非常誘惑,這個想法下能夠展示出的Demo、優秀的AI團隊,可能也是令VC沉醉的。但回顧NLP的歷史,如果Copy.AI、Jasper.AI並未在2020年OpenAI研發出GPT-3並開放接口后再選擇創業,而是在2015年、2018年拿着當時的模型去選擇做營銷助手的創業,其成功的概率會有多大?而從目前的市場情況來看,圖像、視頻領域則尚未出現與Jasper.AI和Copy.AI類似的、已經實現超過千萬ARR的新的應用類創業公司,更多是原來已經存在的應用公司通過新的模型進行業務能力的增加。相信除了Stable Diffusion模型開源的時間尚短以外,也有着當前最好的模型亦尚未成熟的原因。也許,在圖像等其他內容領域,目前時代還在呼喚着與OpenAI類似的提供API的基礎設施類公司,然後才是應用生態繁榮的開始。

參考國外AIGC不同類型的公司出現的節奏,可以發現如下規律:

第一步,頂級實驗室研發革命性的模型

第二步,實驗室或者AI科學家成立基礎設施公司,提供API和模型對外服務

第三步,具備行業經驗的產品人才利用基礎設施公司提供的API,專註於打磨自身應用,服務客戶

從NLP到其他模態(如圖像、視頻、3D等),以上規律反覆出現。

當前NLP國內外都已經出現基礎設施公司提供API接口,國外有OpenAI、Cohere等公司,國內也出現了智譜華章這樣研發出超大規模預訓練模型(效果在多個公開評測集上性能超過GPT-3)並提供模型服務市場(Model as a Service)的基礎設施公司。

有了基礎設施公司提供相對成熟的API服務,啟明創投將持續關注NLP殺手級應用;而圖像、視頻、3D等領域,尚未出現能夠提供商用API的基礎設施公司(Stable Diffusion和Midjourney有可能是第一批圖像領域的基礎設施公司)。

啟明創投同樣會關注在大模型時代前就成立,專註於垂直領域的應用公司,他們將在新一波AIGC浪潮中藉助大模型的能力,推出新產品和或者大幅提升原有產品效果(例如Notion和RunwayML)。此外,在兩個世界過渡的過程中,能夠拿到高額融資的垂直一體AI公司仍然有可能在時間窗口中佔據有利地位(例如AI21lab和Character.ai),我們對此類機會同樣保持關注,但會更加謹慎。

當然,就像是恐龍時代中,哺乳動物作為弱小的生物並不顯眼,但卻最終面對各種惡劣的環境生存下來並開枝散葉一樣。從2012年AlexNet取得深度學習里程碑式的突破以來,啟明創投在過去的十年中都是中國最活躍的人工智能投資機構之一,我們見證了人工智能從算法到應用的一次次突破和發展,對人工智能的前景我們始終保持着熱情和理智。我們將對目前發展的元學習、新一代AI推理或者其他使用更小數據量和參數量的模型發展保持關注,也許未來有一天transformer不再是最優範式,垂直應用的世界會再次到來。

但是,在此之前,第二種世界向第一種世界的過渡看起來無法避免,要知道雖然恐龍最終滅絕,但滅絕之前,他們曾作為霸主統治地球1.6億年。

本文鏈接:https://www.8btc.com/article/6791840

轉載請註明文章出處